Em um mundo onde a tecnologia avança a passos largos, o deep learning se destaca como uma ferramenta poderosa e, ao mesmo tempo, um tanto misteriosa. As redes neurais, que são a espinha dorsal do deep learning, mostram um desempenho surpreendente, desafiando as expectativas teóricas. Mas, afinal, por que o deep learning funciona tão bem? Um estudo recente se aprofundou nessa questão, buscando desvendar os segredos por trás do sucesso das redes neurais e trazer clareza para esse campo fascinante da inteligência artificial.

## Desvendando o Sucesso do Deep Learning

Durante anos, os pesquisadores se perguntaram como as redes neurais conseguiam generalizar tão bem, mesmo com limitações teóricas. O estudo em questão explora o conceito de “soft inductive bias” para explicar esse fenômeno. Essa generalização, essencial para o sucesso das redes neurais, está intimamente ligada à forma como elas compactam as informações.

Para entender melhor, imagine que as redes neurais são como artistas que aprendem a pintar. Elas observam muitos exemplos e, com o tempo, desenvolvem um estilo próprio que lhes permite criar novas obras de arte. Da mesma forma, as redes neurais aprendem a reconhecer padrões nos dados e a usá-los para fazer previsões precisas.

A capacidade de generalização das redes neurais é o que as torna tão úteis em uma variedade de aplicações, desde o reconhecimento de imagens até o processamento de linguagem natural. No entanto, essa capacidade também é um mistério, já que as teorias clássicas de aprendizado de máquina preveem que as redes neurais deveriam falhar em muitos casos.

### As Teorias Por Trás da Generalização

O estudo apresenta cinco estruturas teóricas diferentes que ajudam a explicar a generalização das redes neurais. Essas estruturas oferecem perspectivas únicas sobre como as redes neurais aprendem e como elas conseguem aplicar o que aprenderam a novos dados.

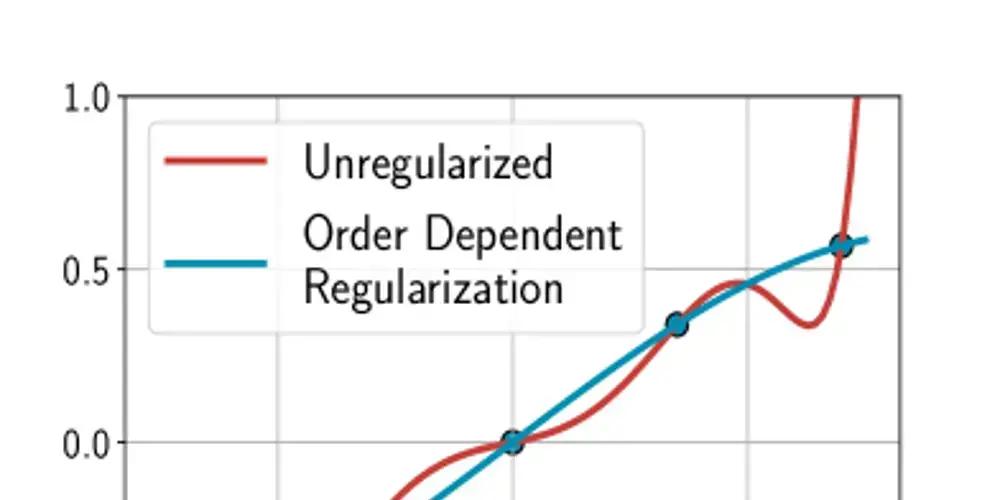

Uma das estruturas teóricas, por exemplo, se concentra na ideia de que as redes neurais aprendem a comprimir as informações de forma eficiente. Essa compressão permite que as redes neurais capturem os padrões mais importantes nos dados e ignorem o ruído. Além disso, a simplicidade do treinamento e a compressão dos dados são fatores cruciais para entender o funcionamento do deep learning.

Outra estrutura teórica explora a relação entre a arquitetura da rede neural e sua capacidade de generalização. Essa estrutura sugere que redes neurais com certas arquiteturas são mais propensas a generalizar do que outras.

### A Simplicidade do Treinamento e a Compressão de Dados

A simplicidade do treinamento e a compressão dos dados são fatores cruciais para entender o funcionamento do deep learning. As redes neurais aprendem ajustando seus parâmetros internos para minimizar o erro entre suas previsões e os valores reais. Esse processo de treinamento pode ser surpreendentemente simples, mesmo para redes neurais muito grandes.

A compressão de dados também desempenha um papel importante no sucesso do deep learning. As redes neurais aprendem a representar os dados de forma compacta, o que lhes permite armazenar e processar grandes quantidades de informações de forma eficiente. Além disso, a compressão de dados ajuda as redes neurais a generalizar, pois as força a se concentrarem nos padrões mais importantes nos dados.

É importante notar que o deep learning está transformando a área de desenvolvimento de software, com a inteligência artificial abrindo novas possibilidades e tornando os softwares mais eficientes e inteligentes.

## O Enigma da Generalização em Redes Neurais

No campo do aprendizado de máquina, existe um quebra-cabeça que intriga os pesquisadores há anos: as redes neurais deveriam falhar de acordo com a teoria, mas, na prática, elas têm um desempenho brilhante. A teoria clássica do aprendizado, baseada no trabalho de cientistas como Vladimir Vapnik, sugere que a capacidade de generalização de um modelo depende de sua complexidade. Modelos mais complexos, como as redes neurais profundas, têm mais capacidade de “memorizar” os dados de treinamento, mas também são mais propensos a se ajustarem demais a esses dados e terem um desempenho ruim em novos dados.

No entanto, na prática, as redes neurais profundas frequentemente superam os modelos mais simples, mesmo quando têm muito mais parâmetros do que dados de treinamento. Esse fenômeno desafia a teoria clássica do aprendizado e levanta a questão: como as redes neurais conseguem generalizar tão bem, apesar de sua complexidade?

### A Importância da Validação Cruzada

Uma técnica fundamental para avaliar a capacidade de generalização de um modelo é a validação cruzada. Essa técnica envolve dividir os dados em várias partes e treinar o modelo em algumas dessas partes, usando as partes restantes para testar seu desempenho. A validação cruzada ajuda a estimar o quão bem o modelo se sairá em novos dados e a evitar o overfitting.

No entanto, mesmo com a validação cruzada, o sucesso das redes neurais profundas permanece um mistério. As redes neurais frequentemente têm um desempenho muito melhor do que o previsto pela validação cruzada, o que sugere que elas estão aprendendo algo mais do que apenas memorizar os dados de treinamento.

### A Busca por Explicações

Os pesquisadores têm proposto várias explicações para o sucesso das redes neurais profundas. Uma dessas explicações é a ideia de que as redes neurais aprendem a representar os dados de forma hierárquica, capturando padrões em diferentes níveis de abstração. Essa representação hierárquica permite que as redes neurais generalizem para novos dados, mesmo que esses dados sejam diferentes dos dados de treinamento.

Outra explicação é a ideia de que as redes neurais são capazes de encontrar soluções “boas” para problemas de aprendizado, mesmo que existam muitas soluções possíveis. Essas soluções “boas” são caracterizadas por serem simples e robustas, o que as torna mais propensas a generalizar para novos dados.

Se você gosta de games, não deixe de conferir os lançamentos da semana, com destaque para Rise of the Ronin e WWE 2K25.

## O Futuro do Deep Learning

O deep learning continua a evoluir rapidamente, com novas arquiteturas de redes neurais e algoritmos de treinamento sendo desenvolvidos constantemente. À medida que o campo avança, é importante continuar a investigar os fundamentos teóricos do deep learning para entender melhor por que ele funciona e como podemos usá-lo de forma mais eficaz.

A compreensão dos princípios por trás do sucesso do deep learning pode levar a novas aplicações e a melhorias nas técnicas existentes. Além disso, essa compreensão pode ajudar a evitar os perigos do overfitting e a garantir que as redes neurais sejam usadas de forma responsável e ética.

As aplicações do deep learning são vastas e estão em constante expansão. Desde carros autônomos até assistentes virtuais, o deep learning está transformando a maneira como interagimos com o mundo ao nosso redor. À medida que o campo continua a amadurecer, podemos esperar ver ainda mais aplicações inovadoras do deep learning no futuro.

Primeira: Este conteúdo foi auxiliado por Inteligência Artificiado, mas escrito e revisado por um humano.

Segunda: Uma frase em itálico “Via e então insira o nome do site que foi usado como referência como âncora do link de referência https://dev.to/mikeyoung44/why-deep-learning-works-the-simple-science-behind-neural-network-success-11ec com tag nofollow. Por exemplo: Via Nome do site do RSS