A compressão de memória com IA está transformando a análise de documentos, permitindo que modelos de linguagem grande (LLMs) processem informações de forma mais eficiente. Uma nova abordagem, focada na tarefa em questão, consegue reduzir o uso de memória em até 8,6 vezes, mantendo uma precisão de 95%. Essa técnica supera os métodos tradicionais de RAG ao incorporar o raciocínio específico da tarefa, adaptando a compressão com base no conteúdo do documento e nas necessidades da consulta.

Compressão de memória com IA Aumenta a Eficiência na Análise de Documentos

A compressão de memória é um desafio constante no desenvolvimento de inteligência artificial, especialmente quando se trata de modelos de linguagem grandes (LLMs). Esses modelos, que são a espinha dorsal de muitas aplicações de processamento de linguagem natural, exigem quantidades massivas de memória para operar de forma eficaz.

Uma nova pesquisa introduz uma abordagem inovadora para a compressão de memória, chamada task-aware KV cache compression. Essa técnica visa otimizar o uso da memória, permitindo que os LLMs realizem raciocínios mais complexos com documentos externos extensos.

O principal objetivo é melhorar o desempenho dos LLMs em tarefas que exigem o uso de grandes volumes de informação. Ao comprimir a memória de forma inteligente, é possível reduzir os custos computacionais e aumentar a velocidade de processamento, tornando a análise de documentos mais acessível e eficiente.

Essa abordagem resolve as limitações das janelas de contexto nos sistemas LLM existentes, que muitas vezes têm dificuldades em lidar com documentos muito longos ou complexos. Ao adaptar a compressão com base na tarefa específica e no conteúdo do documento, a técnica oferece uma solução mais flexível e eficaz.

Desempenho e Vantagens da Compressão de Memória

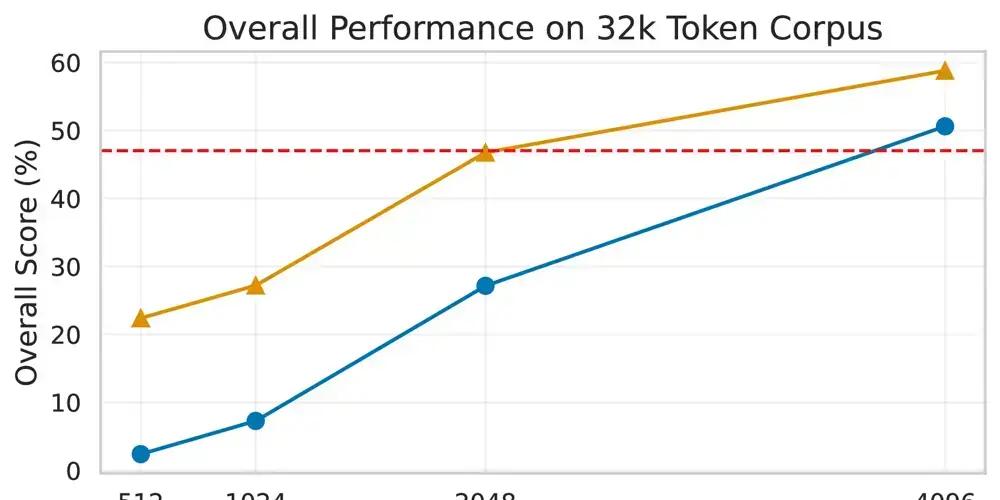

A nova técnica de compressão de memória alcança uma redução de 8,6 vezes no uso de memória, mantendo uma precisão de 95%. Isso significa que os LLMs podem processar muito mais informações usando os mesmos recursos de hardware, sem comprometer a qualidade dos resultados.

Essa abordagem supera os métodos tradicionais de RAG (Retrieval-Augmented Generation) ao incorporar o raciocínio específico da tarefa. Em vez de simplesmente recuperar passagens relevantes e adicioná-las ao prompt, a técnica de compressão permite que o modelo compreenda e sintetize informações de forma mais eficaz.

Uma das principais vantagens é a capacidade de adaptar automaticamente a compressão com base no conteúdo do documento e nas necessidades da consulta. Isso significa que o modelo pode se concentrar nas informações mais relevantes para a tarefa em questão, ignorando o ruído e os detalhes desnecessários.

Além disso, a técnica de compressão de memória aborda as limitações das janelas de contexto nos sistemas LLM existentes. Ao permitir que os modelos processem documentos maiores e mais complexos, ela abre novas possibilidades para aplicações como análise jurídica, pesquisa científica e atendimento ao cliente. Com o aumento da popularidade dos dispositivos móveis, os consumidores estão buscando por aparelhos mais rápidos e eficientes, com mais recursos e conectividade.

Essa tecnologia tem um grande potencial para melhorar a forma como os LLMs interagem com grandes volumes de informação. Ao reduzir os custos computacionais e aumentar a velocidade de processamento, ela pode tornar a análise de documentos mais acessível e eficiente para uma ampla gama de aplicações.

Em resumo, a compressão de memória com task-aware KV cache compression representa um avanço significativo no campo da inteligência artificial, oferecendo uma solução mais eficiente e flexível para o processamento de grandes volumes de informação.

Este conteúdo foi auxiliado por Inteligência Artificiado, mas escrito e revisado por um humano.